- 国内版「Pixel 4」「Pixel 4 XL」に新しい「Google アシスタント」がた

- UI が刷新

- できることは基本的に同じ

2020 年 2 月 4 日に、「Pixel 4」「Pixel 4 XL」の目玉機能となる画面非タッチによるエア操作「Motion Sense(モーションセンス)」の日本国内解禁が発表されましたが、それと同時に新しい「Google アシスタント」の国内提供も発表されていたことを覚えているでしょうか。

その新しい「Google アシスタント」、いつの間にか私手持ちの「Pixel 4 XL」に来ていました。今回その簡単なご紹介です。

「Motion Sense」の国内提供に合わせて発表された新しい「Google アシスタント」は、「Pixel 4」「Pixel 4 XL」の Android OS とアプリをこれまでよりも密接に統合し、アプリや WEB サイトの起動や末設定などを、これまでよりも素早く行うことができるようになる、ある意味新機能。

例えば、音量の設定や Wi-Fi の ON / OFF、「YouTube 」の操作など、様々に活用可能で、最大の特徴は、これまで「Google アシスタント」に指示したタスクがインターネットを介してクラウドに情報わたり、そして端末に返ってくるという流れとなっていたのが、新しい「Google アシスタント」では一部の指示をデバイス上で処理することにより、これまでよりも高速なタスク処理が可能となっている点です。Google の長年にわたる音声処理技術や自然言語処理技術など、AI 研究開発が進んだことに実現した新機能となっています。

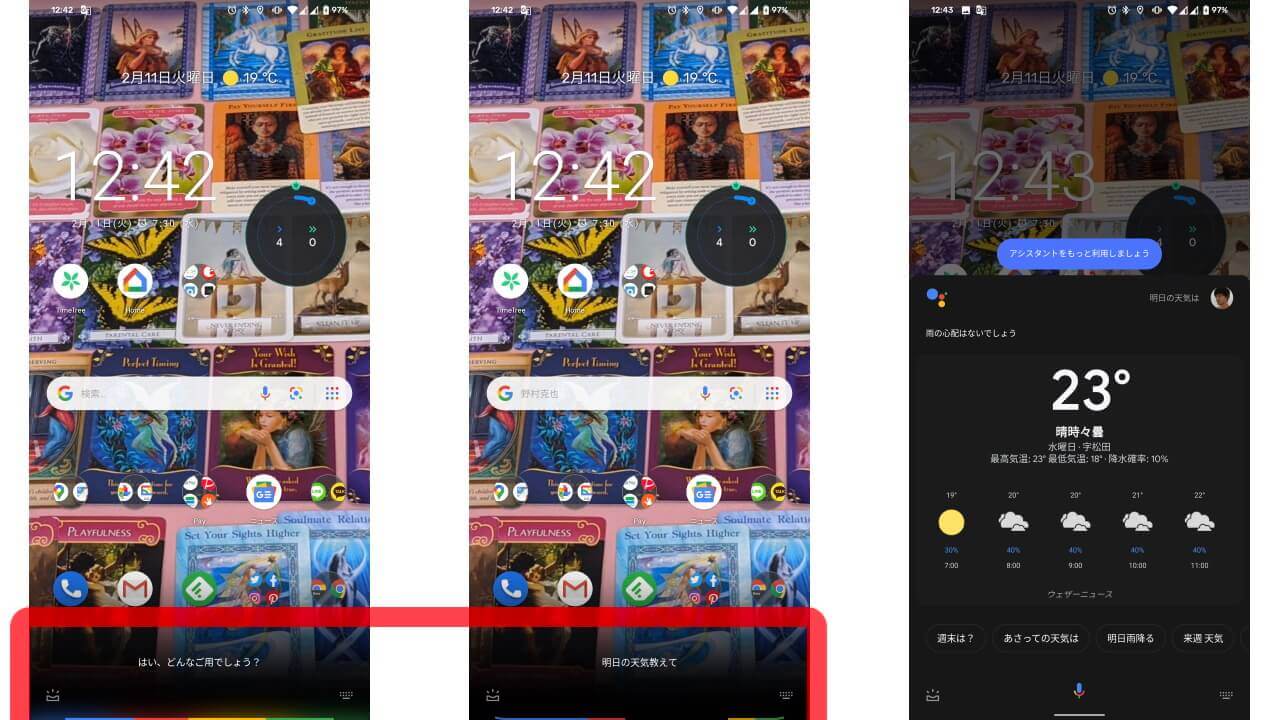

そんな新しい「Google アシスタント」ですが、できることは基本的に以前と同じ。“OK Google” や “ねぇ Google” はもちろん、本体を握って「Google アシスタント」を起動する「Active Edge」や、「ジェスチャーナビゲーション」利用時に画面左右どちらか下からの斜め上スワイプ操作で、これまでと同じく「Google アシスタント」が起動します。

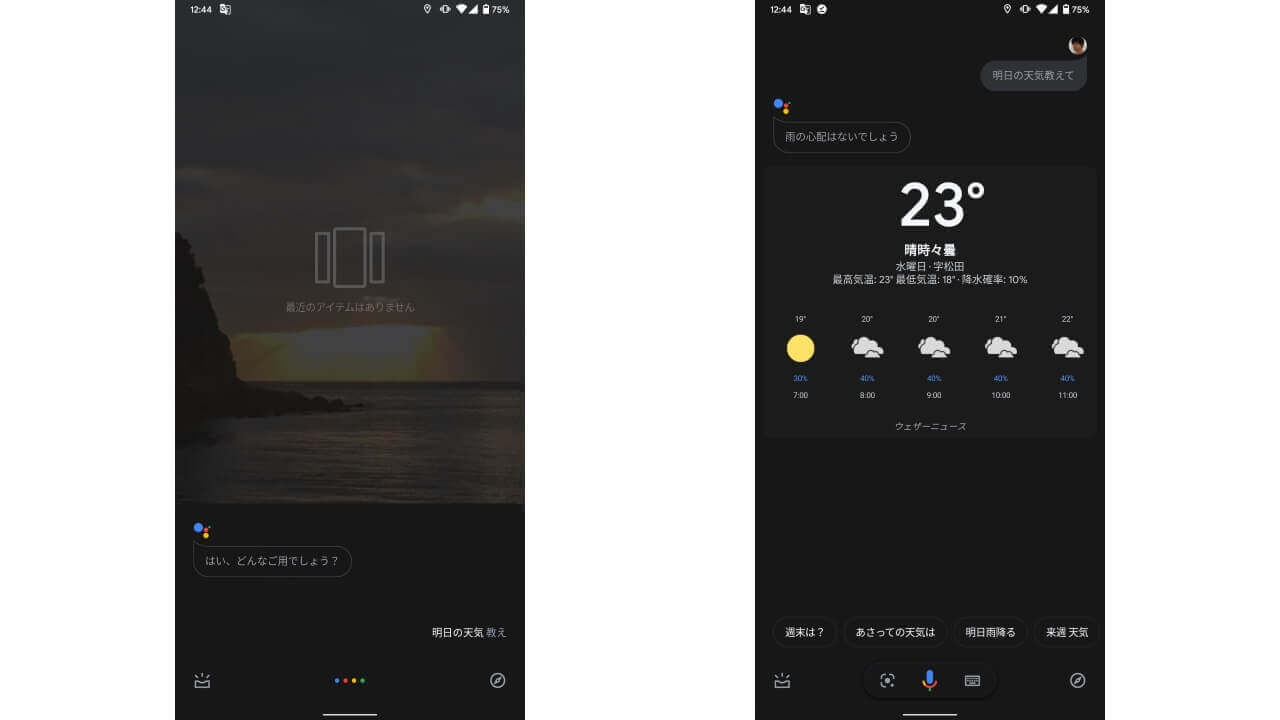

しかしこれまでと UI が異なる点は一目瞭然。ボイスコマンドによる指示までは画面下部のみ、ボイスコマンド後は画面半分程度が、「Google アシスタント」のウィンドウとして出現します。

これまでの「Google アシスタント」と比べるとわかりやすいですね。

見ためてわかる変化はこの程度です。実際の機能面でも進化している部分があるかと思いますが、正直まだよくわかりません。

いろいろと使ってみて、何かお伝えできるような情報があれば、改めてご報告させていただきます。