先日 Google が、Pixel スマートフォン向けにカメラを利用したアシスタント機能「Google レンズ」を海外で提供開始したこと発表しましたが、日本国内でも暫定的に利用できたのでご報告させていただきます。

「Google レンズ」

「Google レンズ」は、カメラで撮影した被写体やテキストに関する情報を読み取って的確な情報を表示してくれるアシスタント機能です。

似たような機能で、ディスプレイに表示されている情報を読み取ってそれに合った情報などを表示してくれる Android の機能「Now on Tap」がありますが、「Google レンズ」はスマートフォンで撮影した写真に写る被写体の情報を表示してくれる「Now on Tap」のような機能というわけです。

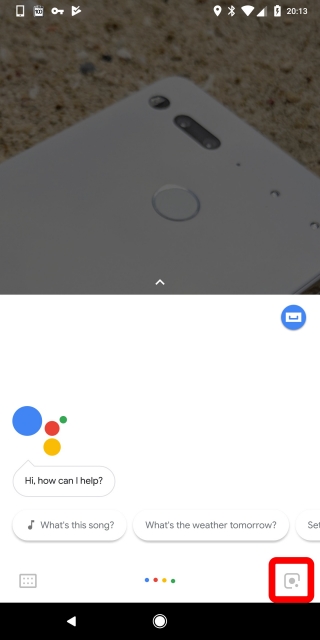

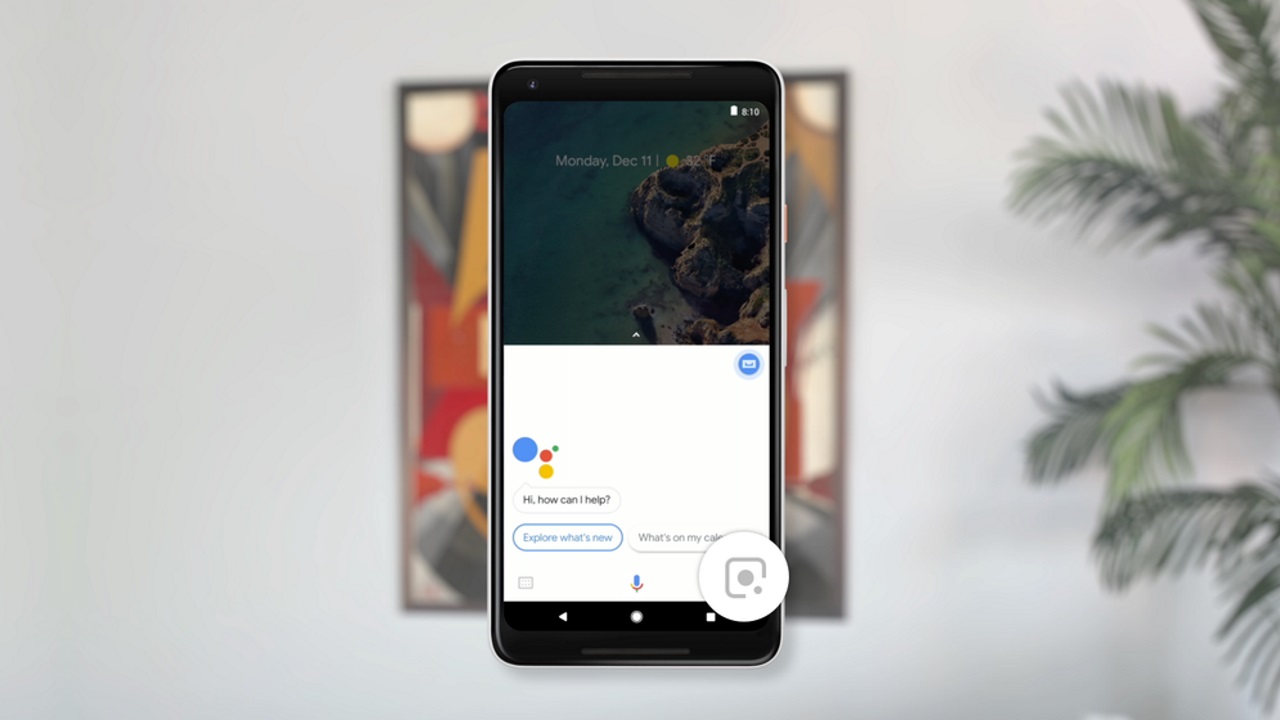

「Google レンズ」は今のところは Pixel スマートフォン向けにプレビュー版としてリリースされていて、当初は「Google フォト」アプリ内で利用することができるようになっていました。そして新たに米国、英国、オーストラリア、カナダ、インド、シンガポールの 6 カ国において、「Google アシスタント」の画面右下に「Google レンズ」アイコンが表示され、そこから「Google レンズ」を起動できるようになりました。

ただし日本では提供されていないので、「Google アシスタント」版「Google レンズ」は、実質的には日本語での利用を行うことはできませんが。そもそも Pixel シリーズは、日本で出ていないですからね。

言語を変更すれば利用可能

がしかし、(個人的な予想通り)言語を英語に変更したら日本国内でも「Google アシスタント」版「Google レンズ」を利用することができました。

もちろん表示言語は英語に切り替わるので、英語環境限定での暫定的な開放ということになります。

使いか方は簡単で、「Google アシスタント」を起動し更に右下に表示される「Google レンズ」アイコンをタッチして、カメラが起動したら被写体にカメラを向けてディスプレイをタッチするのみです。瞬時に被写体の読み込みが行われ、その被写体に関する情報が表示されます。

試しに「Android One X1」を写してみたところ、“Android One X1” として認識してくれました。“Android One X1” をタッチすると更に、Google 検索の検索結果がカード形式で表示されます。

ちなみに「Google レンズ」を使用してもカメラ撮影が行われるわけではないので、単純に被写体の情報を知りたい場合にガンガン活用できそうでした。ただ「Google フォト」版「Google レンズ」のようなアニメーションがない点は、ちょっと物足りなさも感じましたね。

「Google アシスタント」版「Google レンズ」は今後改良が重ねられると共に日本語を含めた複数の言語にも対応すると予想されるので、今後に期待です。